Une étude universitaire menée sur l’Autopilot des Tesla et le système Mobileye 630 PRO des Renault et des Mazda démontre les limites des assistants de conduite. Ils sont notamment incapables de différencier des images projetées d’objets réels, et semblent ignorer le contexte dans lequel ils les détectent.

Les systèmes de conduite automatisée ou semi-automatisée ont encore beaucoup de progrès à faire pour offrir un niveau de sécurité satisfaisant. Si l’Autopilot des Tesla semble encore disposer d’une certaine avance sur ses concurrents, l’assistant montre rapidement ses limites. Il est capable de reconnaitre une zone de chantier, mais peut également confondre un t-shirt orange avec un plot. La législation européenne a d’ailleurs imposé à Tesla de limiter ses fonctionnalités par mesure de sécurité.

Le code source des assistants de conduite n’est pas public, il est donc difficile de prévoir leur comportement face une situation donnée. C’est justement l’objet d’une étude d’universitaires qui ont tenté de déterminer le degré d’« intelligence » des systèmes qui conduisent nos voitures. Sans grande surprise, l’interprétation de leur environnement reste assez basique, et peut facilement les tromper.

Les assistants de conduite disposent d’une IA trop limitée

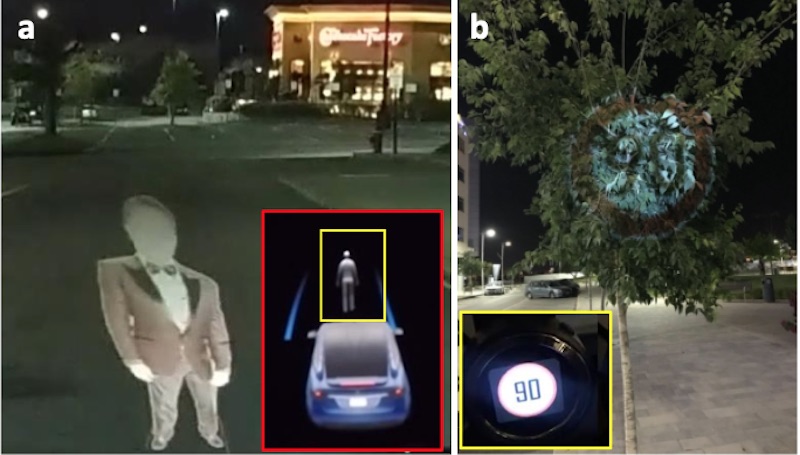

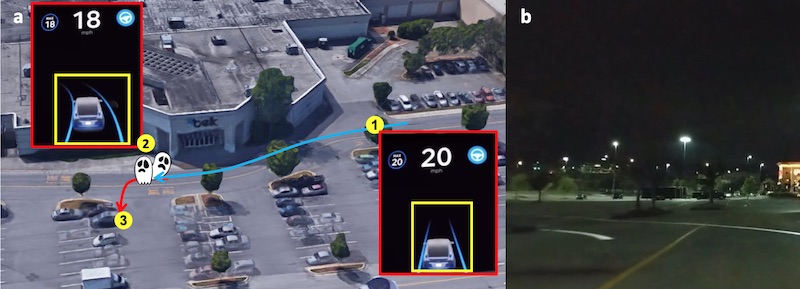

L’étude a été menée sur l’Autopilot d’une Tesla Model X en version 2.5, mais aussi avec le système Mobileye 630 PRO qui équipe les véhicules Honda, Mazda et Renault. Les chercheurs ont mis en place plusieurs scénarios pour illustrer le comportement des assistants, et mettre en avant leurs principaux défauts. Les premiers essais ont montré que les systèmes sont incapables de discerner une image d’un objet réel. L’image d’une voiture ou d’un piéton provoque l’arrêt du véhicule.

De la même manière, on peut modifier la trajectoire du véhicule en projetant des lignes blanches sur le sol. Si plusieurs lignes sont présentes, l’IA semble choisir les plus marquées pour déterminer la direction à suivre.

D’autres expérimentations montrent que les intelligences artificielles ignorent complètement le contexte dans lequel elle repère un objet. Ça ne semble leur poser aucun problème qu’un panneau de signalisation soit projeté sur un arbre, sur la route ou dans la vidéo d’un panneau d’affichage. On peut même leur indiquer une limitation de vitesse plus élevée qu’à l’emplacement GPS où elle se situe. Le problème est d’autant plus ennuyeux que la signalétique fantôme n’a pas besoin d’être visible très longtemps. L’afficher pendant seulement quelques centièmes de seconde suffit au système pour la prendre en compte.

Tesla réfute que ses voitures accélèrent toutes seules

L’étude a été transmise à Mobileye et à Tesla qui connaissent certainement les limites de leurs systèmes. On peut s’attendre à des progrès significatifs pour mieux identifier un être humain ou un autre véhicule, mais d’autres défauts semblent insurmontables, notamment différencier un vrai panneau de signalisation d’un faux. Elon Musk promettait une conduite entièrement automatisée dès 2019, il faudra probablement attendre encore quelques années avant de pouvoir s’en remettre complètement à une IA.

Tesla : l’Autopilot la rend 6,4 fois plus sûre qu’une voiture classique

Source : Phantom of the ADAS: Phantom Attacks on Driving Assistance Systems