Sora est le dernier modèle d’intelligence artificielle d’Open AI. Après le chatbot intelligent ChatGPT et le générateur d’images DALL-E, les développeurs se sont ici concentrés sur la vidéo. Avec un prompt de seulement quelques phrases, il est possible d’obtenir une vidéo réaliste. Voici tout ce qu’il faut savoir à propos de cette nouvelle IA, qui promet de révolutionner à son tour bien des secteurs.

- 🪄 Qu’est-ce que Sora ?

- 🖼️ Comment fonctionne Sora ?

- ▶️ De quoi est capable Sora ?

- 😒 Quelles sont les limites de Sora ?

- 💀 Sora peut-il être dangereux ?

- 🔒 Comment OpenAI compte garantir la sécurité de ses utilisateurs ?

- 📅 Quand Sora sera t-il disponible ?

- 🤔 Sora arrivera t-il sur ChatGPT ?

- 🆚 Quels sont les concurrents de Sora ?

Les progrès en matière d’IA avancent à vitesse grand V, et ce n’est pas OpenAI qui dira le contraire. Après le succès de ChatGPT, l’entreprise a récemment dévoilé Sora. Son nouvel outil d’intelligence artificielle générative est capable de créer des vidéos ultra réalistes à partir d’un simple prompt textuel. Le générateur est pour le moment en mesure de réaliser des extraits dont la durée n’excède pas une minute. S’il promet des possibilités inédites en matière de création artistique, Sora laisse également présager de nombreuses dérives. En effet, l’outil offre des rendus très réalistes qui pourraient en faire un outil de désinformation très efficace. Dans ce dossier, on vous dit tout ce qu’il y a à savoir à son sujet.

🪄 Qu’est-ce que Sora ?

Sora est un modèle d’IA capable de créer des vidéos réalistes à partir d’instructions textuelles. Développée par OpenAI, l’entreprise à l’origine du chatbot ChatGPT et du générateur d’images artificielles DALL-E, Sora a été dévoilée le 15 février 2024. Les développeurs travaillent activement sur leur modèle texte-vidéo. Afin de l’enrichir, ils collaborent notamment avec des experts de différents secteurs : artistes, designers, cinéastes, etc.

Bien que Sora ne soit pas encore tout à fait au point, il produit d’ores et déjà des vidéos d’une qualité impressionnante, qui amincissent de plus en plus la frontière entre fiction et réalité. Les utilisateurs peuvent décrire la scène qu’ils souhaitent voir prendre vie. L’IA est alors en mesure de l’interpréter en tenant compte des interactions complexes entre objets et personnages.

Conscient des potentielles dérives de son modèle, notamment d’un point de vue éthique avec la création de deepfakes, OpenAI assure mettre tout en œuvre pour protéger le monde contre ces risques, en élaborant notamment des outils de détection.

Un outil aussi puissant promet de révolutionner la création artistique, notamment dans les domaines cinématographiques, de l’animation 3D ou encore du jeu vidéo. OpenAI voit quant à lui Sora comme une composante supplémentaire, qui lui permettra d’atteindre à terme l’IAG (ou AGI en anglais) : Intelligence Artificielle Générale. Selon Wikipédia, cette notion renvoie à la capacité pour une IA “d’effectuer ou d’apprendre pratiquement n’importe quelle tâche cognitive propre aux humains ou autres animaux“. Pour le moment, cela fait référence à la science-fiction. Mais dans un futur plus ou moins proche, il pourrait s’agir de la forme d’intelligence qui animera de potentiels robots humanoïdes.

🖼️ Comment fonctionne Sora ?

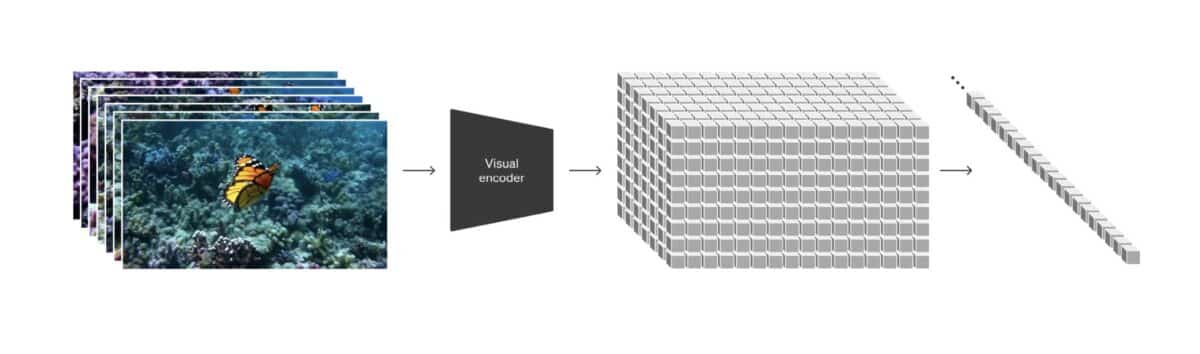

Semblable aux autres modèles GPT, Sora utilise une architecture de transformateur. Les vidéos générées ne sont en rien l’œuvre d’une entité pensante. Elles sont en réalité la résultante de différentes connexions opérées par de puissants algorithmes. Les modèles de langage utilisent des jetons (tokens) qui permettent d’organiser un texte en petites unités plus simples à analyser. C’est le même principe pour Sora, qui utilise toutefois des patchs correctifs, semblables à ceux utilisés dans le domaine de la visualisation de données.

Pour bien comprendre le processus, il faut se représenter des millions de petites unités de données, couvrant chacune différentes notions. Ces données renferment énormément d’informations descriptives et visuelles. En piochant dans cette gigantesque base de données, Sora est ensuite capable de reconstituer une vidéo en mettant en relation les différentes notions qui ressortent dans l’invite. Ce qui permet d’obtenir un résultat fidèle aux instructions textuelles fournies par l’utilisateur. Le modèle utilise en ce sens la même technique de récapitulation que le générateur d’images DALL-E 3.

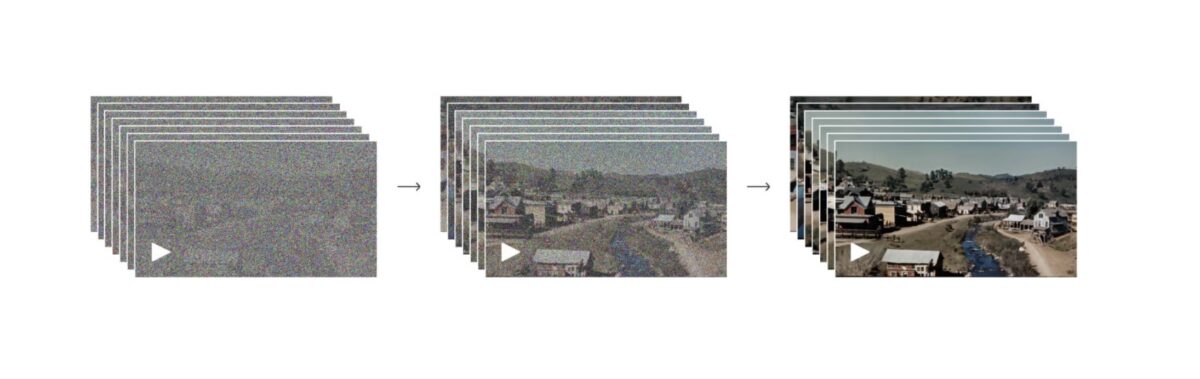

Cette représentation basée sur des correctifs visuels permet à Sora de s’entraîner sur des vidéos et des images de résolutions, durées et formats variables. En tant que transformateur de diffusion, Sora passe par plusieurs étapes successives pour générer une vidéo. Comme on peut le voir dans la représentation ci-dessous, le modèle part d’un format brut, composé de bruit statique. La qualité des échantillons augmente au fur et à mesure. Ce qui a pour effet de supprimer le bruit et de laisser place à une image propre, en haute résolution. Pour en savoir plus, on vous invite à consulter ce rapport technique d’OpenAI, qui entre encore plus dans les détails.

À lire aussi : quels sont les meilleurs générateurs d’images propulsés par l’IA ?

▶️ De quoi est capable Sora ?

À ce jour, Sora est capable de générer des vidéos d’une durée maximale d’une minute. Il peut reproduire des scènes complexes mettant en lumière plusieurs personnages, ainsi qu’une multitude de détails, qu’il s’agisse des sujets ou du décor. Il est par ailleurs à même de générer plusieurs plans au sein d’une même vidéo, ou encore de reproduire des émotions complexes. Le modèle assure d’autre part des transitions fluides, ainsi que le maintien de la cohérence des personnages et des scènes.

En plus de pouvoir générer une vidéo uniquement à partir d’instructions textuelles, Sora est capable de générer une vidéo à partir d’une image fixe existante. Pour ce faire, le modèle va animer le contenu de l’image à sa disposition, en prêtant attention aux petits détails. Sora peut également s’appuyer sur une vidéo existante afin de l’étendre ou d’ajouter des images manquantes. À l’occasion d’une interview donnée à The Wall Street Journal, Mira Murati, la directrice technique chez OpenAI, a expliqué que l’outil se dotera également de fonctionnalités audio. Ce qui devrait offrir un rendu encore plus immersif.

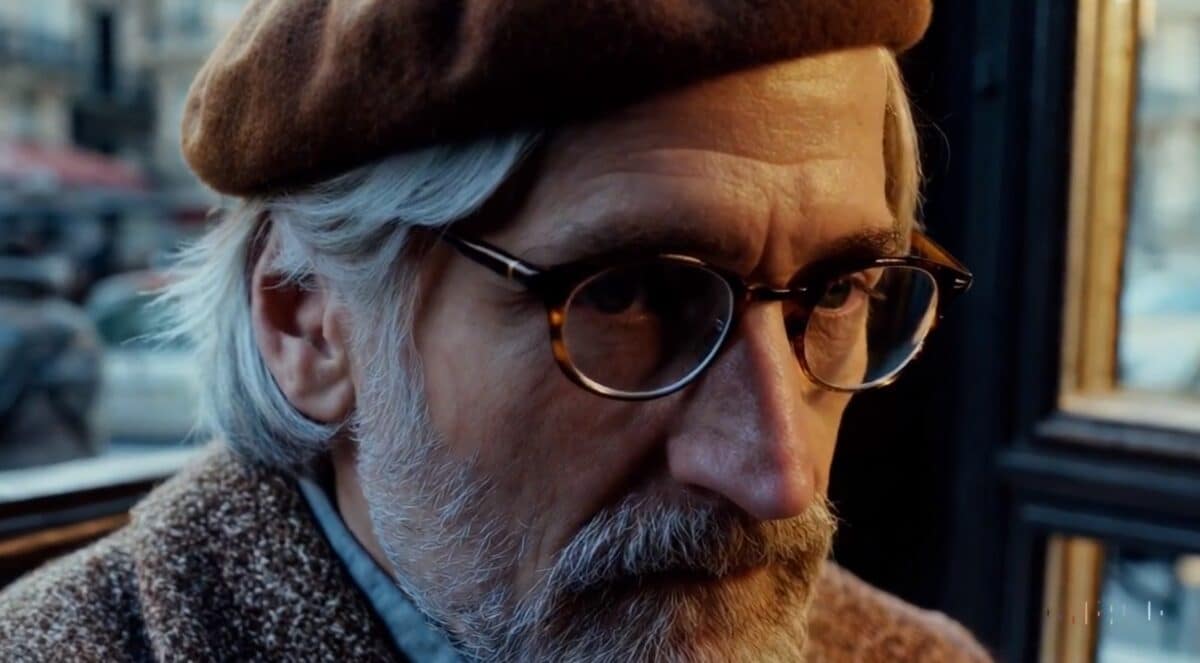

La vidéo ci-dessus à été générée à partir d’un simple prompt de quelques lignes seulement. Comme on peut le voir, elle respecte l’invite texte. L’IA a conféré des traits asiatiques à la femme, en se basant sur l’information “Tokyo”. Vous pouvez visionner le résultat sur le site officiel d’Open AI. Une floppée d’autres vidéos sont disponibles. Les résultats sont bluffants, bien qu’il reste encore beaucoup de choses à améliorer.

La photo ci-dessus est tirée d’une vidéo partagée sur le site d’OpenAI. Elle montre une fois de plus à quel point le rendu et les détails sont d’une précision extrême. Les cils, les grains de la peau, ou le reflet de la rétine contribuent à rendre l’image réaliste. À l’inverse, Sora permet aussi aux créatifs de laisser libre cours à leur imagination en créant des scènes totalement fantaisistes. Car c’est aussi ça la magie de l’IA.

😒 Quelles sont les limites de Sora ?

Malgré les prouesses de Sora, le modèle est encore loin d’être parfait. L’image ci-dessous montre encore qu’il reste du travail à accomplir pour obtenir un rendu véritablement capable de tromper l’œil. Si l’on s’attarde quelque peu sur les pattes du chat, on constate vite que quelque chose ne tourne pas rond. En effet, le chat a trois pattes avant. D’autre part, le nez de la femme semble être dans une position particulièrement inconfortable, pourtant blotti contre un gros oreiller.

Ces quelques erreurs sont récurrentes sur les autres modèles GPT. Si vous avez déjà utilisé DALL-E 3 à partir de ChatGPT Plus, vous ne devriez pas être surpris. En effet, il n’est pas rare que le modèle génère un troisième bras ou place un sujet dans une position peu réaliste.

Par ailleurs, Sora peut également avoir du mal à simuler avec précision la physique d’une scène complexe, ainsi que certains cas spécifiques de cause à effet. Par exemple, la photo ci-dessous montre une personne âgée qui souffle sur les bougies de son gâteau d’anniversaire. Problème, celles-ci ne s’éteignent pas.

Rappelons toutefois que la création de vidéo assistée par IA n’en est qu’à ses débuts. Bien que la plupart des résultats actuels soient déjà très satisfaisants, la marge de progression reste énorme.

À lire aussi : GPT-5 s’annonce beaucoup plus performant que GPT-4.

💀 Sora peut-il être dangereux ?

Au vu de la vraisemblance des résultats obtenus avec ce générateur de vidéos, plusieurs menaces planent à l’horizon. En effet, Sora, ainsi que d’autres technologies similaires posent un réel défi sociétal en matière de sécurité et d’éthique. La désinformation, déjà bien en place dans notre société, pourrait fortement être accentuée avec l’essor d’un tel système. De plus et associée au clonage vocal, cette technologie pourrait pousser le deepfake à un niveau encore jamais vu.

On imagine sans trop de difficulté le fait de pouvoir par exemple faire dire ou faire faire des choses à des personnes, sans que cela n’ait réellement eu lieu. Cela est d’ailleurs déjà le cas sur TikTok. Le droit à l’image se retrouverait ainsi fortement menacé. Ceci soulèverait également de graves problèmes face à la justice, pour qui les vidéos sont considérées aujourd’hui comme des preuves de tout premier ordre. D’autre part, des fraudeurs, hackers ou autres personnes malintentionnées pourraient également se servir de cette technologie pour usurper l’identité d’autrui, voire pour demander une rançon. Quoi qu’il en soit, Sora et les autres modèles du genre pourraient mettre l’humanité dans une bien mauvaise posture. Une situation à laquelle elle n’avait jamais eu à faire face jusqu’à présent.

Pour le moment, et bien que les rendus soient déjà très réalistes, il est encore possible de déceler d’éventuelles erreurs. Mais qu’en sera t-il le jour où ces vidéos seront aussi vraies que natures, et qu’il ne sera plus possible de différencier le vrai du faux ?

🔒 Comment OpenAI compte garantir la sécurité de ses utilisateurs ?

Afin de s’inscrire dans une démarche responsable, OpenAI a annoncé développer en parallèle des outils qui permettront de détecter les contenus vidéo trompeurs créés par l’IA. Parmi eux, on compte notamment un classificateur de détection. La firme prévoit également d’inclure des métadonnées C2PA, qui permettront de vérifier si une vidéo a été créée avec Sora ou non. En revanche, ces dernières ne constituent pas une solution très fiable, étant donné qu’elles peuvent facilement être retirées.

L’entreprise a également prévu d’exploiter les mesures de sécurité existantes, notamment utilisées pour DALL-E 3. Il ne sera par exemple pas possible de saisir une invite qui enfreint les politiques d’utilisation d’OpenAI. À savoir, pour créer par exemple un contenu à caractère sexuel, haineux, ou qui suggère une violence extrême. D’autre part, et afin de lutter contre les deepfakes, il ne sera pas non plus possible de créer des personnages qui ressemblent aux célébrités.

OpenAI avertit que malgré toutes les mesures mises en place, il n’est à ce stade pas possible de prédire toutes les utilisations, qu’elles soient bénéfiques ou abusives. Ainsi, il faudra attendre la sortie du modèle pour voir comment les gens l’utilisent, et prendre des mesures correctives si nécessaire. Le but étant bien entendu de proposer un système de plus en plus sûr au fil du temps.

À lire aussi : comment reconnaître les images générées par l’IA ?

📅 Quand Sora sera t-il disponible ?

L’outil n’est actuellement pas disponible pour le grand public. Il n’est donc pas possible d’essayer Sora pour le moment. En effet, OpenAI réserve pour l’heure un accès privilégié aux membres de l’OpenAI Red Teaming Network. À l’instar de béta testeurs, ces derniers ont à charge de tester l’outil et de faire remonter d’éventuels problèmes techniques, éthiques ou légaux. Cela dans le but de permettre un déploiement responsable de l’outil.

Comme nous l’avons expliqué en début d’article, OpenAI accorde également un accès à une poignée d’artistes, cinéastes et designers triés sur le volet. En tant qu’experts dans leurs domaines respectifs, leurs retours, qu’ils soient positifs ou négatifs, vont permettre de faire avancer le modèle dans la bonne direction. Quoi qu’il en soit, l’outil s’annonce déjà prometteur, et grâce à cet apport, il pourrait l’être encore plus à sa sortie, qui n’a pas encore été annoncée. Toutefois, Mira Murati, la directrice technique d’OpenAI a récemment annoncé que l’outil pourrait être disponible d’ici quelques mois.

À lire aussi : tout savoir sur GPT-5 : date de sortie, nouveautés, etc.

🤔 Sora arrivera t-il sur ChatGPT ?

On ne sait pas encore comment le grand public pourra accéder à Sora. Toutefois, si l’on se base sur le mode de distribution de DALL-E 3, il est fort probable que le modèle d’IA texte-vidéo soit lui aussi intégré sous forme de plugin dans ChatGPT Plus. En effet, au vu de la puissance de l’outil, on doute qu’Open AI mette à disposition son générateur de vidéo gratuitement. Si tel est le cas, il pourrait être déployé sur GPT-5.

À lire aussi : les 10 meilleurs plugins à utiliser sur ChatGPT.

🆚 Quels sont les concurrents de Sora ?

La génération de vidéos assistée par IA est un domaine en pleine expansion. Avec Sora, OpenAI doit faire face à une concurrence rude, qui cherche également à s’imposer sur le marché. Toutefois et au vu des résultats partagés par tous les concurrents, Sora semble être pour l’heure le plus puissant de tous les outils. Voici quelques-uns des acteurs les plus notables dans ce secteur :

- Google : connu pour être en avance dans le domaine de l’IA, le géant américain travaille lui aussi sur un modèle de diffusion texte-vidéo. Baptisé Lumière, il est non seulement capable de créer des vidéos à partir de texte, mais également en se basant sur une image. Il est aussi possible de générer des vidéos en utilisant le style d’une image, mais également de styliser des vidéos déjà existantes, d’animer une région spécifique d’une image, ou encore de rajouter des éléments sur une vidéo. Le modèle semble toutefois être pour l’heure moins puissant que Sora. La durée des vidéos ne pouvant excéder 5 secondes. Et aussi moins réaliste, comme en atteste la vidéo ci-dessous.

- Meta : le groupe de Mark Zuckerberg est également en première ligne avec son modèle Make-A-Video. Il est possible d’obtenir trois types de rendus : réaliste, surréaliste ou stylisé. Le générateur de vidéo par IA de Meta utilise une méthode différente (Text-to-Video) des autres acteurs qui utilisent pour la plupart le Texte-to-Image, comme cela est le cas de Sora. Tout comme l’outil de Google, les vidéos réalisées semblent moins réalistes et durent moins de 5 secondes.

- Runway : en plus de vous permettre de créer une vidéo à partir de texte, l’outil Gen-2 vous permet de convertir une image en vidéo, de styliser une vidéo en partant d’une image de référence, mais également d’appliquer des modifications en isolant le sujet d’une vidéo via l’application d’un masque. L’outil de création générative est disponible et permet de créer de courts extraits vidéo allant de 4 à 16 secondes.

- Stability AI : cette start-up britannique est un autre concurrent sérieux de Sora. Connu pour son générateur d’images Stable Diffusion, l’entreprise a récemment déployé son modèle Stable Video Diffusion à des fins de tests. En se basant sur un prompt textuel, ce dernier est capable de créer entre 14 et 25 images par vidéo, à des fréquences de rafraîchissement personnalisables entre 3 et 30 images par seconde. Les vidéos sont pour le moment limitées à 5 secondes.

- Pika Labs : cette société spécialisée dans l’IA a également développé un générateur de vidéos. Ce dernier est capable de transformer du texte ou une image en une courte animation de 3 secondes, qu’il est possible de prolonger. Pika 1.0 vous permet aussi de modifier une vidéo existante. Vous pouvez par exemple changer son style ou ajouter des éléments. Il est également possible de faire parler vos personnages grâce à un simple prompt. L’outil offre la possibilité de générer différents styles de vidéos. De l’animation 3D, aux dessins animés, en passant par un style cinématographique. Il est actuellement possible de l’essayer gratuitement.

À lire aussi : Alibaba présente EMO, une IA générative capable de donner vie à vos photos.