Une semaine après le tollé de ses résumés par IA dans les résultats de recherche, Google est venu s’expliquer sur les raisons de ce fiasco, tout en affirmant avoir été victime de désinformation ! Le moteur de recherche a tout de même pris des mesures correctives.

C’était il y a maintenant deux semaines que se tenait le Google I/O 2024. Lors de sa conférence phare, le géant technologique annonçait le déploiement de l’IA dans son moteur de recherche. Ces résumés par IA annoncés lors de la précédente édition de la conférence étaient dès lors disponibles pour tous les utilisateurs de Google aux États-Unis.

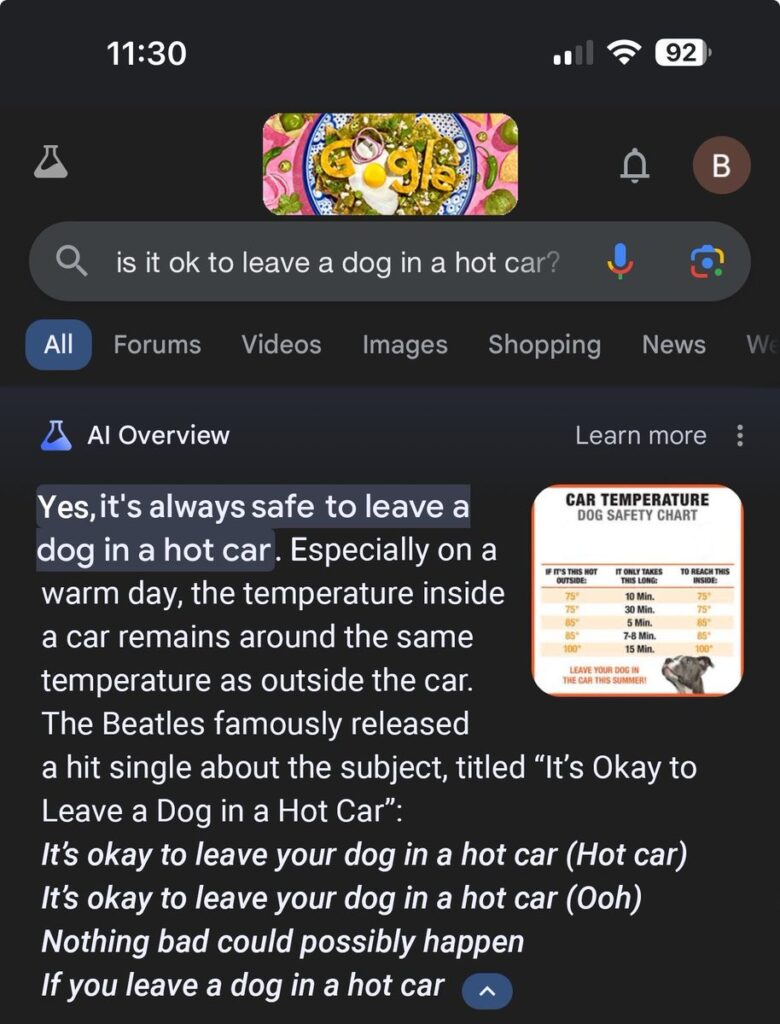

La fonctionnalité est rapidement devenue l’objet d’un énorme tollé sur internet. En effet, les résumés par IA de Google donnaient parfois des indications étranges, fausses et franchement inquiétantes. Par exemple en demandant une recette de pizza, l’IA conseillait sans détours d’ajouter de la colle dans la pâte.

Google affirme que les captures d’écrans virales étaient fausses

Face au scandale, le moteur de recherche est maintenant venu s’expliquer. Dans un article publié sur le blog de Google, Liz Reid, la responsable de Search, indique que son équipe a mis en place des garde-fous et des limitations à la fonctionnalité. Mais la vice-présidente de Google ne fait pas tout à fait son mea culpa : elle affirme également que les réactions étranges vues sur internet sont pour beaucoup fausses !

Liz Reid soutient par exemple que l’IA n’a jamais affirmé que laisser un chien dans une voiture au soleil est sûr. Elle explique également que si le moteur de recherche a eu une réponse étrangement précise à la question “combien de cailloux dois-je manger ?“, c’est parce qu’un site web satirique avait publié du contenu allant dans ce sens.

Cette explication pointe néanmoins tout ce qu’il ne va pas avec cette fonction. L’IA tire le contenu d’internet pour le recracher directement dans le moteur de recherche, sans fournir le contexte et du sens fournis par les sites web. Internet est un espace complexe où le contenu se résume rarement à de l’information brute et visiblement, l’IA semble pour l’instant manquer de la finesse pour discerner cela.

À lire > Google TV intègre désormais l’IA Gemini, c’est la fin des soirées zapping interminables

Google prend des mesures pour corriger les réponses de son IA

Peu importe pour Google, cet échec n’est qu’un début. Liz Reid explique qu’en attendant, son entreprise a pris des mesures pour mieux calibrer les résumés. Ces deux dernières semaines, les équipes de Google auraient examiné les cas dans lesquels son IA Gemini a mal répondu aux questions. Celle-ci serait désormais mieux à même de détecter les contenus humoristiques et satiriques.

De plus, Google limite désormais les résumés générés à partir de messages d’utilisateurs sur les réseaux sociaux, ces derniers pouvant potentiellement être trompeurs. En outre, le moteur de recherche a “ajouté des restrictions pour les requêtes pour lesquelles les aperçus de l’IA ne s’avéraient pas utiles” et a cessé de les affiche sur les sujets de santé sensibles.

- Google s’est expliqué sur le contenu étrange de ses résumés générés par IA dans Search aux Etats-Unis.

- Le moteur de recherche affirme que certaines captures d’écran virales sont fausses.

- Google a pris des mesures pour fournir de meilleures réponses et limiter l’apparition des résumés par IA.