Pris la main dans le sac ? Un article, publié dans une grande revue scientifique, a été retiré car il avait été écrit par ChatGPT, le célèbre chatbot d’OpenAI. L’article contenait une phrase qui trahissait son utilisation. Les auteurs n’avaient pas révélé leur recours à l’IA, ce qui constitue une violation des politiques éthiques du journal.

Après cet homme qui aura gagné des millions en rédigeant ces livres avec le chatbot, voilà qu’un article scientifique, publié dans le journal Physica Scripta, a été retiré après que les auteurs ont été découverts en train d’utiliser l’application d’intelligence artificielle ChatGPT pour l’écrire.

Une erreur qui nous fait repenser, par exemple, à ces étudiants lyonnais qui ont fait appel à ChatGPT pour rendre leur devoir maison et qui se sont fait avoir.

Un article scientifique rédigé par ChatGPT retiré d’un journal après deux mois de publication

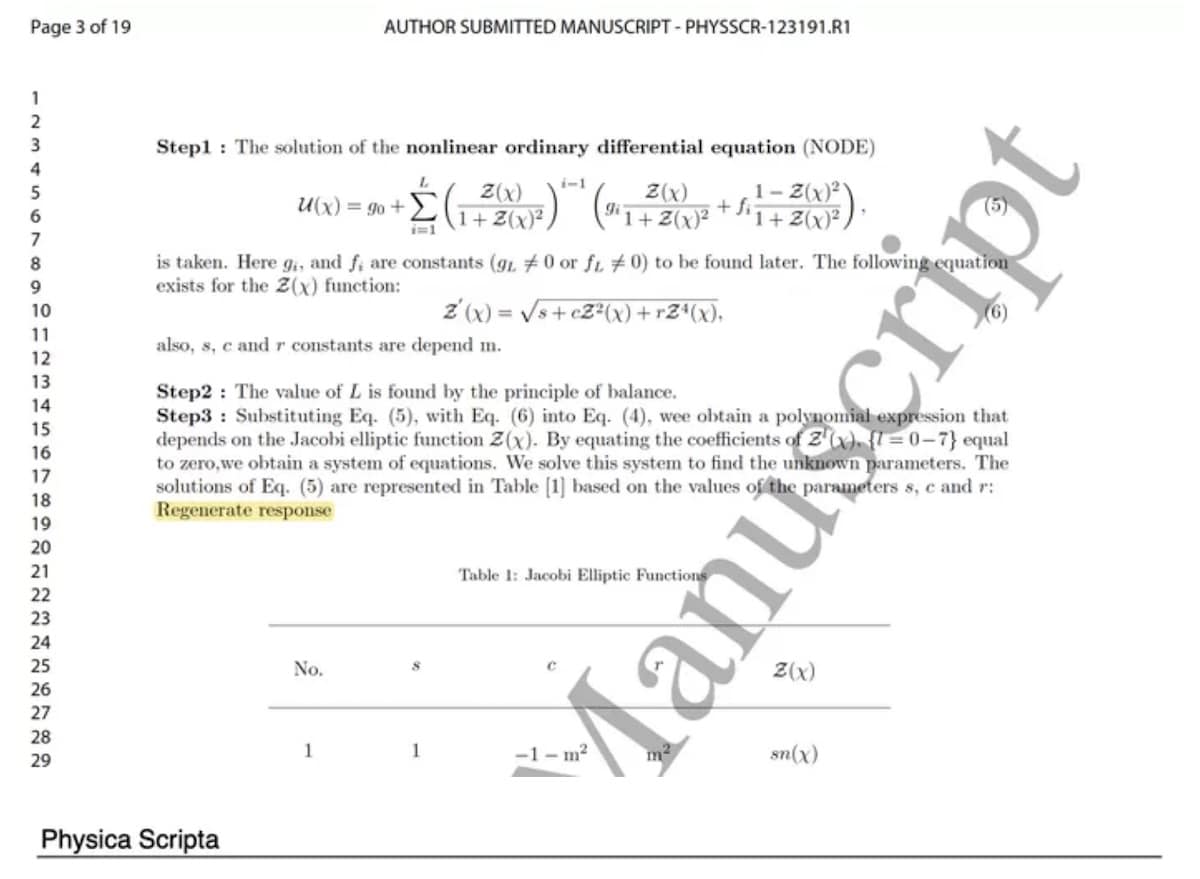

L’article, paru le 9 août dernier dans cette revue scientifique internationale de physique expérimentale et théorique, tentait de trouver de nouvelles solutions à une équation mathématique complexe. En revanche, il contenait la fameuse phrase « Regenerate response » à la troisième page, un indice qui a permis à un lecteur attentif de reconnaître qu’il s’agissait du bouton présent sur ChatGPT.

Les auteurs de l’article ont admis qu’ils avaient fait appel à ChatGPT pour le rédiger, mais il sera resté publié pendant près de deux mois. Cette révélation a poussé l’éditeur britannique à retirer l’article, car les auteurs n’avaient pas révélé l’utilisation de l’IA lors de sa publication.

À lire : ChatGPT : 4 choses à ne surtout pas faire quand vous utilisez la célèbre IA

Cette « bourde » de copier-coller a été repérée par le scientifique informatique Guillaume Cabanac, enseignant-chercheur en informatique à Toulouse, qui s’est donné pour mission personnelle depuis 2015 de débusquer les articles qui ne sont pas transparents sur leur utilisation de l’IA. À côté, des modèles d’IA sont développés pour détecter ChatGPT, comme GPTZero, créé par Edward Tian, étudiant à l’Université de Princeton.

Pour certains scientifiques et chercheurs, le processus de révision par les pairs de la publication d’articles est censé être rigoureux, mais le volume de la recherche publiée fait que certaines choses passent entre les mailles du filet. David Bimler, un chercheur qui traque également les faux articles, a déclaré à Futurist qu’ils n’ont tout simplement pas le temps de tout vérifier.

Source : PubPeer