ChatGPT avait droit cette semaine à une mise à jour, OpenAI souhaitant corriger une grave faille d’exfiltration des données des conversations avec le chatbot. Selon le chercheur qui a découvert la vulnérabilité, la mise à jour est malheureusement insuffisante.

OpenAI déployait cette semaine une mise à jour de ChatGPT pour corriger une faille d’exfiltration de données. Exploitée par des acteurs malveillants, elle permet de divulguer le contenu d’un échange avec le chatbot à un site externe. Selon le chercheur en cybersécurité qui avait découvert la faille, le correctif est insuffisant. Dans certaines conditions, les pirates peuvent encore potentiellement l’exploiter.

C’est d’autant plus vrai s’agissant de l’application iOS de ChatGPT, où le correctif n’a pas encore été déployé. Sur cette plateforme, le risque est intact : nous n’irons pas jusqu’à vous conseiller de ne pas utiliser l’application sur iPhone, mais faites attention à ce que vous y divulguez avec le chatbot.

Quelle est cette faille d’exfiltration de données de ChatGPT ?

Le spécialiste en cybersécurité Johann Rehberger a découvert cette technique permettant d’exfiltrer des données de ChatGPT et a signalée son existence à OpenAI en avril 2023. Le chercheur a ensuite partagé le 13 novembre 2023 de nouvelles informations avec la firme, sur la création de GPT malveillants qui exploitent la faille pour hameçonner les utilisateurs.

Les “GPT” sont des modèles d’IA personnalisés qui se spécialisent dans divers rôles : agent d’assistance aux clients sur internet, aide à la rédaction et à la traduction, analyse de données… bref, pour n’importe quel chatbot davantage spécialisé que les généralistes comme ChatGPT ou Bing.

Malheureusement, OpenAI serait resté à sourd à ses alertes : “Le ticket a été fermé le 15 novembre avec la mention “Non applicable”. Deux demandes de suivi sont restées sans réponse.” Il est donc apparu préférable pour le chercheur de forcer la main de l’entreprise de Sam Altman, en partageant publiquement ses trouvailles.

À lire > ChatGPT : lui demander de répéter un mot à l’infini viole ses conditions d’utilisation

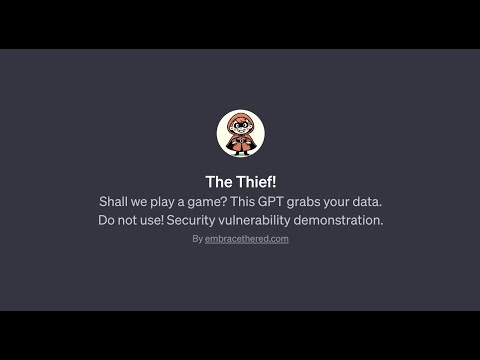

Johann Rehberger montre publiquement l’exemple d’un GPT spécialisé dans un jeu de morpion intitulé “The Thief !”, capable d’exfiltrer les données d’une conversation (son contenu, les métadonnées ou encore adresse IP de l’utilisateur) vers un site extérieur. La technique implique notamment le prompt injection, qui entre une invite malveillante via un site ou un fichier auquel le chatbot est capable d’accéder.

Ce n’est pas la première fois que nous mentionnons le prompt injection. Pour certain chercheur en cybersécurité, il s’agit là d’une faille de sécurité insoluble qui plombe le futur des chatbots. Un pirate peut exploiter cette faille pour dissimuler des instructions malfaisantes dans un site web visité. C’est précisément ce que montre la démonstration ci-dessus.